Llama 3.3 คืออะไร?

Llama 3.3 คือโมเดลภาษาขนาดใหญ่ (Large Language Model) ที่พัฒนาโดย Meta AI ซึ่งออกแบบมาเพื่อตอบโจทย์นักพัฒนาที่ต้องการใช้ AI ประสิทธิภาพสูงโดยไม่ต้องลงทุนในฮาร์ดแวร์ราคาแพง

ด้วยจำนวนพารามิเตอร์ 70 พันล้านตัว Llama 3.3 มอบประสิทธิภาพเทียบเท่ากับโมเดลขนาดใหญ่กว่า เช่น Llama 3.1 405B แต่มีข้อได้เปรียบสำคัญคือการใช้ทรัพยากรน้อยกว่าและสามารถรันบน GPU ทั่วไปได้อย่างมีประสิทธิภาพ

Llama 3.3 ทำงานอย่างไร?

Llama 3.3 ใช้โครงสร้าง Transformer-based Architecture ที่มีการปรับปรุงใหม่เรียกว่า Grouped-Query Attention (GQA) ซึ่งช่วยให้โมเดลสามารถประมวลผลข้อความได้เร็วขึ้นและใช้ทรัพยากรหน่วยความจำลดลง

ขั้นตอนการฝึกโมเดล:

- Supervised Fine-Tuning (SFT): โมเดลถูกปรับแต่งด้วยข้อมูลที่คัดเลือกมาอย่างดี เพื่อให้ตอบสนองอย่างมีประสิทธิภาพ

- Reinforcement Learning with Human Feedback (RLHF): การเก็บข้อมูลจากความคิดเห็นของผู้ใช้งานจริงเพื่อนำมาปรับปรุงพฤติกรรมของโมเดล

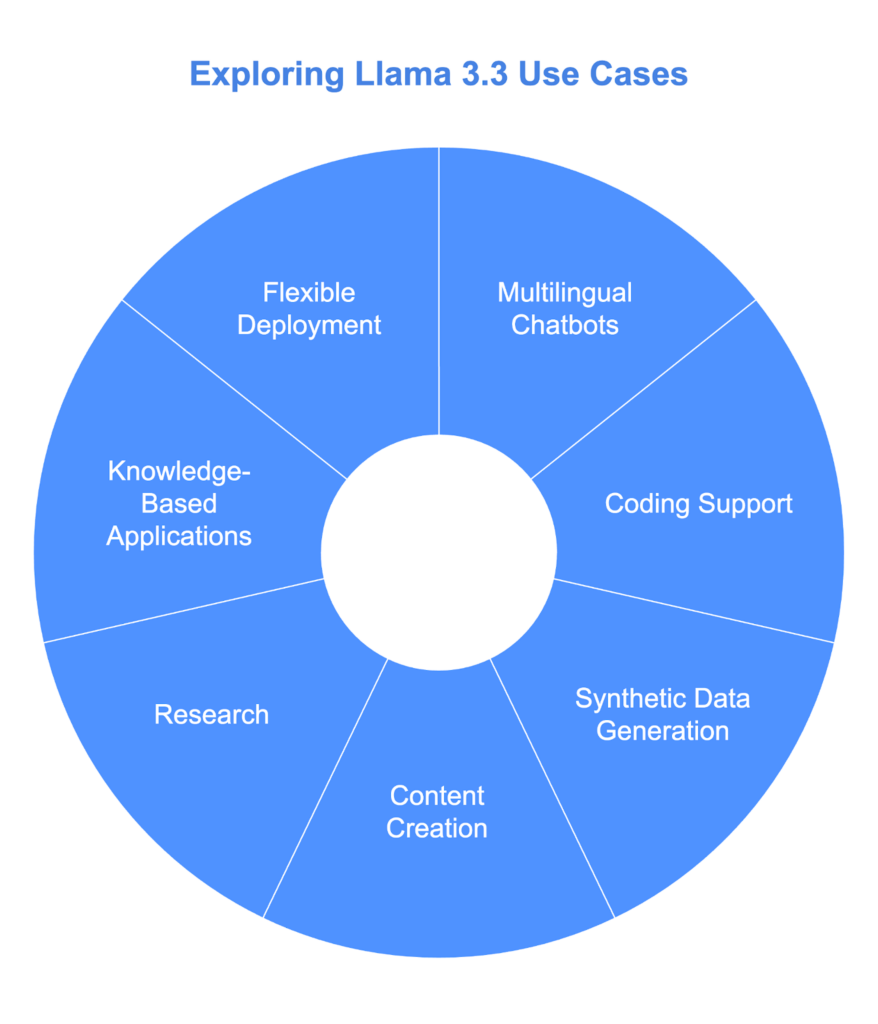

Llama 3.3 ใช้ทำอะไรได้บ้าง?

- สร้างแชทบอทหลายภาษา:

Llama 3.3 รองรับ 8 ภาษา เช่น อังกฤษ สเปน ฮินดี และเยอรมัน ทำให้เหมาะสำหรับสร้างแชทบอทเพื่อการสนับสนุนลูกค้าในหลายประเทศ - ช่วยเขียนโค้ด:

โมเดลนี้สามารถช่วยนักพัฒนาในการเขียนโค้ด ตรวจสอบข้อผิดพลาด หรือสร้างสคริปต์ที่ยังเขียนไม่เสร็จ - สร้างข้อมูลสังเคราะห์ (Synthetic Data):

เหมาะสำหรับนักวิจัยที่ต้องการสร้างข้อมูลเพื่อการฝึก AI โดยไม่ต้องใช้ทรัพยากรสูง - สร้างคอนเทนต์หลายภาษา:

ช่วยสร้างเนื้อหา เช่น บทความหรือสื่อการตลาด ในหลายภาษา ลดความจำเป็นในการจ้างนักแปล - วิจัยและทดลอง:

Llama 3.3 เป็นเครื่องมือที่มีประสิทธิภาพสำหรับงานวิจัยด้าน AI โดยเฉพาะการปรับปรุงโมเดลหรือทดสอบเทคนิคใหม่

ประสิทธิภาพของ Llama 3.3 เมื่อเทียบกับโมเดลอื่น

- การตอบสนองตามคำสั่ง (Instruction Following): Llama 3.3 ได้คะแนน 92.1 บน IfEval ซึ่งสูงกว่า Llama 3.1 405B

- การสร้างโค้ด (Coding): มีคะแนน 88.4 บน HumanEval ซึ่งอยู่ในระดับแนวหน้า

- การรองรับหลายภาษา: มีคะแนน 91.1 บน MGSM ซึ่งเป็นตัวเลือกที่ยอดเยี่ยมสำหรับแอปพลิเคชันหลายภาษา

ราคา Llama 3.3

- ต้นทุนการประมวลผลอินพุต: $0.1 ต่อ 1 ล้านโทเค็น

- ต้นทุนการประมวลผลเอาต์พุต: $0.4 ต่อ 1 ล้านโทเค็น

เปรียบเทียบกับคู่แข่ง เช่น Amazon Nova Pro ($0.8) และ GPT-4o ($2.5) ถือว่าคุ้มค่ากว่ามาก

บทสรุป

Llama 3.3 คือการก้าวกระโดดของ AI ที่เน้นประสิทธิภาพและความเข้าถึงง่าย เหมาะสำหรับนักพัฒนา นักวิจัย และทีมงานขนาดเล็กที่ต้องการเครื่องมือ AI ที่ทรงพลังแต่ไม่ต้องการฮาร์ดแวร์ระดับสูง

คำถามที่พบบ่อย

- Llama 3.3 รองรับกี่ภาษา?

รองรับ 8 ภาษา เช่น อังกฤษ สเปน ฮินดี และเยอรมัน - โมเดลนี้เหมาะกับใคร?

เหมาะสำหรับนักพัฒนา นักวิจัย และผู้ประกอบการที่ต้องการใช้ AI ในระดับสูงแต่มีข้อจำกัดด้านทรัพยากร - Llama 3.3 ใช้งานบนฮาร์ดแวร์ทั่วไปได้หรือไม่?

ได้ โมเดลนี้ออกแบบมาเพื่อใช้งานบน GPU ทั่วไป